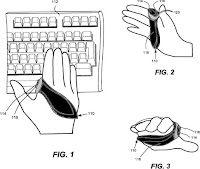

La división de hardware de Microsoft ha creado un concepto de ratón que facilitaría el paso de escribir a usar el ratón, además de mejorar la postura y reducir el cansancio de quien lo usa. Si bien la patente para el concepto se hizo en 2006, recién ahora se conoce la misma.

A todos alguna vez nos ha sucedido que el brazo o muñeca nos duela a causa de usar durante un periodo muy prolongado el ordenador, una postura errada o una mezcla de ambas cosas. Esto en general es causado por el hecho de que el modo de usar el ratón no es muy ergonómico y uno debe esforzarse para utilizarlo. Por este motivo Microsoft Hardware creó el concepto de uno que puede ponerse de manera similar a un guante. La patente para este producto fue tramitada en octubre de 2006, aunque ha sido publicada en estos días.

El dispositivo se colocaría alrededor de todos los dedos menos el pulgar, junto al que quedarían los botones de éste, como puede verse en la imagen. De esta manera se puede pasar de usar el ratón a escribir en el teclado más cómodamente. Para utilizar el ratón, se lo activa cerrando la mano y se utiliza del mismo modo que un joystick. De este modo no sería necesario apoyar la mano sobre el escritorio para controlar el ordenador, evitando así forzar los músculos y, en muchos casos, ayudando a mejorar la postura. Debido a lo específica que es la patente respecto a los componentes y el funcionamiento, es probable que ya hayan hecho uno prototipo funcional del dispositivo, aunque no hay imágenes o muestras de este.

Fuente: Istartedsomething

jueves, 17 de abril de 2008

Microsoft ha patentado un ratón tipo guante

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Informatica, Windows

Alcanzando el TeraHertz

Hace no mucho se alcanzó lo que se creía la “velocidad máxima” que podían alcanzar los microprocesadores, pero recientes descubrimientos prometen poder levantar esa velocidad 3 ordenes de magnitud más de lo que hoy es el máximo. Pero pasar de 4GHz a 300GHz o incluso 1000GHz no es fácil, apenas se han creado los equivalentes de los cables para transportar la radiación en la que se basa esta tecnología.

Hace un tiempo se llegó a lo que es el límite de velocidad de los microprocesadores actuales de 4GHz. Esto causó que la guerra de la velocidad cambie por la guerra de los núcleos, primero 2, después 4 y aparentemente la cantidad seguirá subiendo. Con estos nuevos desarrollos la guerra por la velocidad parecía terminada, pero ingenieros de la universidad de Utah están investigando nuevos modos de procesar información para alcanzar velocidades mucho mayores a los 4GHz (Un TeraHertz es igual a 1000GHz).

Actualmente sólo han logrado generar y transmitir una señal de 300GHz (o 0,3 THz) con lo que faltaría generar transistores, switches, moduladores y otros componentes básicos para poder pensar en crear un procesador, pero el potencial es muy grande. Con esta nueva tecnología se eliminarían problemas inherentes a los materiales conductores y así, se aumentaría la velocidad de trabajo. Problemas como son la resistencia que aumenta junto con la velocidad y la temperatura que hay que disipar. Por otra parte, el problema con la aproximación actual de múltiples núcleos es que hay ciertas tareas que no se dividen bien en muchas partes, por dar un ejemplo banal, calcular Pi no es fácilmente paralelizable ya que se necesitan los valores “anteriores” para continuar el cálculo. El efecto práctico de esto es que mientras algunas aplicaciones funcionan mucho más rápido, otras no cambian su velocidad, por lo que agregar núcleos no es la solución final.

El líder del proyecto, Profesor adjunto Ajay Nahata incluso dijo “Apenas hemos creado el equivalente a los cables para los nuevos procesadores” pero en un mínimo de 10 años estos descubrimientos podrían llevar a procesadores y comunicaciones súper rápidos (3 ordenes de magnitud más rápidos de lo que conocemos hoy).

Fuente: Science Daily neoteo.com

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Informatica, Tecnologia

miércoles, 16 de abril de 2008

(España)Denuncian que el Gobierno puede multar a sitios web por disponer de la opción de recomendar a un amigo

Las multas en materia de protección de datos online en España son las más elevadas de Europa, según la Asociación Española de Comercio Electrónico y Marketing (Aecem), que alertó de que los procedimientos y sanciones impuestas llevan a España a ser "menos competitiva que el resto de países de la UE

Así, según la comparativa aportada por Aecem, la sanción máxima en España puede alcanzar los 600.000 euros, mientras que en Francia el importe de la multa es de 150.000 euros la primera vez y de 300.000 en caso de nuevo incumplimiento. En Alemania la sanción asciende a 250.000 euros y en Italia, a 60.000.

Según el presidente de Aecem, Martí Manent, tanto las multas como los procedimientos incoados aumentaron el pasado año, aunque el importe total disminuyó debido a la aplicación de un artículo que contempla rebajas a empresas si muestran una actitud "proactiva". Para Manent, esta apreciación es "arbitraria", y criticó que la Agencia Española de Protección de Datos (AEPG) sancione incluso "a las empresas que disponen de una opción para recomendar la página a un amigo".

"Esta exagerada aplicación de la ley únicamente nos lleva a ser menos competitivos que el resto de los países de la UE, y uno de los que suma más sanciones", insistió el responsable de la asociación. Manent recordó que con las sanciones a las empresas por disponer de la opción de recomendar su web se consigue sólo "poner más trabas al desarrollo de la sociedad de la información en España".

fuente:Europa Press

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: curiosidades, Internet, Noticias

Ponen a la venta en EEUU ordenadores clónicos que pueden ejecutar Mac OS X

Psystar ha comenzado a vender una gama de ordenadores capaces de ejecutar el sistema operativo de Apple. Inicialmente denominados OpenMac, tras unas horas desde su lanzamiento han pasado a llamarse OpenComputer, seguramente para evitarse problemas legales. No son ni de lejos tan bonitos y elegantes como los originales, pero sí más baratos.

Ha reinado la confusión desde que Psystar anunciara la venta de una gama de ordenadores de sobremesa capaces de ejecutar Mac OS X Leopard. Primero los anunciaron con el nombre de OpenMac para luego cambiarlo a OpenComputer sin ofrecer explicación alguna. Es más, en algunos lugares de la web de Psystar aún se les llamaba OpenMac en el momento de escribir estas líneas. También instalan gratuitamente Leopard, aunque el sistema debe adquirirse aparte por los 155 dólares que cuesta en cualquier tienda.

La versión más barata, disponible por 399 dólares y encaminada a competir con Mac Mini, dispone de un procesador Intel Core 2 Duo a 2.2GHz, 2 Gb de memoria DDR2, disco duro de 250 Gb y chip gráfico Intel 950 integrado y una grabadora de DVD. La más cara, etiquetada Pro, . No obstante, siendo ordenadores clónicos, admiten que se configure a gusto del usuario, siempre garantizando la compatibilidad con Mac OS X.

La duda está en si Apple lo permitirá o, para ser más exactos, cuanto tiempo tardarán sus abogados en enfrentarse con Psystar. Un empleado de la empresa ha hablado con Information Week y ha asegurado pensar que cualquier acción por parte de Apple no se sostendría en ningún tribunal, por violación de las leyes antimonopolio.fuente:(Daniel Rodríguez Herrera) libertaddigital.com

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Informatica, Software, Tecnologia

Se viene el Service Pack 3 de Windows XP

Después de muchas idas y vueltas, finalmente se confirma la fecha en la que el Service Pack 3 de Windows XP haría su aparición: el 29 de abril.

Las novedades, asegura MS, serán mínimas y apenas serán notadas por el usuario final. Serán, casi en su totalidad, un rejunte de todas las actualizaciones de seguridad lanzadas hasta al momento.

Primero se decía que el Service Pack 3, de Windows XP, saldría el 24 de marzo pasado. Pero el 24 de marzo llegó, y nada pasó. Ahora, Neowin (la misma fuente que le había errado con la fecha original), reporta que el SP3 de XP estaría listo el 29 de abril. Según el sitio, pudieron acceder al calendario interno de Microsoft y por eso es que ya lo dan por confirmado.

Afirma la fuente que el calendario sería:

- Abril 14, 2008: Se comenzó a brindar soporte para el lanzamiento del Service Pack 3 para Windows XP

- Abril 21, 2008: Se distribuye por medio de los suscriptores de MSDN y TechNet y se instala en equipos de fábrica.

- Abril 29, 2008: Se distribuye por medio de Microsoft Update, Windows Update y el Download Center

- Junio 10, 2008: Ya estaría disponible mediante las Actualizaciones Automáticas del SO.

A esperar, entonces.

Fuente: Max Ferzzola @ neoteo.com

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Informatica, Software, Tecnologia, Windows

lunes, 14 de abril de 2008

Arrebata Uruguay récord Guinness

Hermosillo irá este año por la revancha para recuperar el título mundial de “Capital de la carne asada”, que le arrebató Uruguay el sábado al conseguir el récord Guinness de la parrillada más grande del mundo: 12 mil kilos de res en un asador de 1.5 kilómetros.

“Estamos muy contentos de que lo hayan logrado, esto nos motiva a ir nuevamente por el récord Guinness. Estamos convencidos de que los hermosillenses quieren recuperar el récord y a partir de ahora empezamos a trabajar”, anunció Saúl Rojo Valenzuela.

El presidente del patronato del asilo Juan Pablo II recordó la actividad masiva en la que se asaron 8 mil kilos de diezmillo en mil 50 asadores con un largo total de mil 290 metros y se logró la ansiada inscripción en el libro Guinness, el 20 de noviembre de 2006.

“Romper un récord Guinness no es sencillo, hay que cumplir un procedimiento, nosotros estamos en la categoría de lo que en Estados Unidos sería una barbiquiu”, dijo Rojo Valenzuela.

Quien señaló que el patronato comienza a preparar el próximo evento para el día de asueto por motivo de la Revolución Mexicana: 21 de noviembre de 2008.

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: curiosidades

IBM da el primer paso para desarrollar la tecnología que sustituya a discos duros y memorias Flash

Investigadores de IBM han publicado un artículo en Science donde muestran la manera de llevar a la práctica las llamadas memorias racetrack (pista de carreras), un concepto del que se viene discutiendo desde hace unos años. No obstante, aunque hayan demostrado que se puede construir, aún no lo han hecho. Habrá que esperar seis o siete años a que la tecnología esté disponible en el mercado.

Tradicionalmente, los ordenadores han almacenado la información en discos duros, también invención de IBM, aunque de un tiempo a esta parte las memorias Flash han ido ganando posiciones y ya se venden ordenadores con los denominados "discos de estado sólido", que no son más que memorias Flash de alta capacidad, como las que se incluyen en móviles y reproductores MP3.

Los discos duros son baratos, pero relativamente lentos, tardando unos milisegundos en acceder a los datos, y al estar construidos con piezas móviles, también son frágiles y poco duraderos. Las memorias Flash tienen menor capacidad y una vida útil limitada, pero son más rápidas (en lectura, no en escritura) y fiables. El objetivo de las memorias racetrack sería convertirse en un almacenamiento masivo, barato, rápido y fiable.

Según informa IBM en un comunicado, estas nuevas memorias almacenaría la información en una serie de nanotubos mil veces más finos que un cabello humano en las separaciones entre dominios magnéticos. Impulsos electromagnéticos desde los extremos hacen que esos datos "corran" a lo largo del nanotubo, de ahí el nombre de "pista de carreras". Otro nanotubo sería el encargado de escribir y leer los datos.

Este tipo de memoria tendría 100 veces mayor capacidad que las actuales y podría construirse en tres dimensiones, no sólo en dos, obviando así algunos de los problemas de miniaturización de las memorias actuales.

fuente: libertaddigital.com

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Tecnologia

¿Donde están los ordenadores que hacen funcionar Google?

Los servicios ofrecidos por Google son muchos y requieren del uso de un gran número de ordenadores. ¿Cuántos centros de datos necesita Google para manejar esta ingente información y dónde están situados?

A sus servicios de búsqueda web se suman Gmail, Google Apps, Blogger, Reader o Maps, además de otros muchos servicios menores y otros que tienen en proyecto el gigante de Internet.

Aunque oficialmente la compañía no ha revelado ni el número ni el lugar donde se encuentran los centros de datos que albergan sus ordenadores, que según algunas estimaciones están cerca de alcanzar el medio millón, en Pingdom han elaborado un mapa con los centros de datos conocidos que están activos y otros en construcción. No todos son propiedad de Google; algunos los alquilan a otras empresas.

El coste en 2007 de cuatro de estos centros se elevó según precios oficiales a 2.400 millones de dólares, incluyendo la construcción, el equipamiento y las computadoras. Los criterios de selección para emplazar los mismos se establecen entorno a:

- Grandes cantidades de electricidad barata.

- Energía verde. Google prefiere fuentes de energía renovables.

- Proximidad a ríos y lagos ya que utilizan una gran cantidad de agua para enfriar los ordenadores.

- Grandes extensiones de tierra que les permitan una mayor privacidad y seguridad.

- Distancia a otros centros de datos de Google para poder establecer conexiones de alta velocidad entre ellos.

- Incentivos fiscales.

fuente:LD (Christian Camacho) libertaddigital.com

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Google

viernes, 11 de abril de 2008

Un estudio revela que una gran parte de las computadoras están infectados de virus

Los virus informáticos son un problema muy grave en la informática a pesar de la lucha que se está realizando contra ellos. La empresa de seguridad informática Panda ha realizado un estudio del que se desprende que un 72 por ciento de las compañías y un 23 por ciento de las computadoras domésticos están infectados con malware. Este software se infiltra en las computadoras sin consentimiento y puede provocar que los datos personales de muchos usuarios sean sustraídos, utilizados o incluso que los internautas puedan ser despojados de su dinero.

Los virus informáticos son un problema muy grave en la informática a pesar de la lucha que se está realizando contra ellos. La empresa de seguridad informática Panda ha realizado un estudio del que se desprende que un 72 por ciento de las compañías y un 23 por ciento de las computadoras domésticos están infectados con malware. Este software se infiltra en las computadoras sin consentimiento y puede provocar que los datos personales de muchos usuarios sean sustraídos, utilizados o incluso que los internautas puedan ser despojados de su dinero.

La compañía ha defendido un nuevo modelo basado en la recolección de información sobre malware procedente de la comunidad de usuarios y el procesamiento automatizado de los datos en unos nuevos centros de datos, lo que permite aumentar la capacidad de detección de los software intrusos, que en la actualidad ascienden a más de once millones.

Fuente: libertad digital

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Informatica, Software

Toshiba SpursEngine: HD por hardware

Este nuevo co-procesador de Toshiba promete implementar, por hardware, varios formatos de compresión y descompresión de formatos en alta definición. Esto quitaría un enorme peso del procesador central de un ordenador o podría usarse para grabadores de vídeo digital u otras aplicaciones parecidas.

Toshiba ha comenzado a distribuir su nuevo procesador, basado en la tecnología del procesador Cell de IBM (el de la Playstation 3). Este co-procesador puede implementar de manera muy eficaz algoritmos de compresión y descompresión de vídeo en alta definición, con un consumo reducido (de 10 a 20W). Esto permitiría desarrollar aparatos o placas para ordenadores que puedan manejar una gran cantidad de datos en tiempo real con un consumo energético reducido. Con esto sería posible grabar o ver vídeo de alta definición, cambiar de formato u otros tipos de proceso lineal, sin necesidad de largas esperas o procesadores tan potentes. Como explicábamos hace un tiempo, este procesador está preparado para procesar "torrentes" de datos de manera muy eficiente.

Teniendo en mente que el Cell de IBM es el que se monta en sus servidores o súper computadoras es interesante la idea de tener a disposición ese tipo de potencia para aplicaciones que le sientan como anillo al dedo. Toshiba estará ofreciendo su completo soporte a quien esté dispuesto a desarrollar para el nuevo co-procesador ofreciendo todo lo necesario: placas de referencia, aplicaciones de ejemplo y entorno de desarrollo. Ahora y como muchas otras veces será cosa de esperar a ver cual es el primer dispositivo en montar tan interesante co-procesador.

Fuente: Akihabara News

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Tecnologia

Irlanda: Turbinas submarinas para generar energía con el movimiento del mar

En Strangford Narrows, zona de turbulencias y mar siempre embravecido, se está instalando una megaturbina con aspas de más de 15 metros de largo, que generarán energía suficiente para iluminar más de 1.000 hogares gracias al eterno movimiento de las corrientes submarinas

En Strangford Narrows, zona de turbulencias y mar siempre embravecido, se está instalando una megaturbina con aspas de más de 15 metros de largo, que generarán energía suficiente para iluminar más de 1.000 hogares gracias al eterno movimiento de las corrientes submarinas

Si, lo admitimos, nos preocupa la crisis energética. Sin banderas, estamos hablando de un problema mundial que ya no hace distinción alguna entre países y situación económica.

Porque antes se pensaba que las crisis de este tipo acontecían solo en países subdesarrollados o con una nula planificación de su matriz energética, que les dejaba sin electricidad en los momentos de consumo pico. Pero luego los problemas comenzaron a sucederse en países industrializados, y entonces la excusa es que cuando hay mucha producción a veces el suministro energético está al límite.

Llega entonces el momento de comenzar a analizar como obtener energía a través de métodos no convencionales, como en autopistas gracias al tránsito vehicular. También gracias a rodilleras tech. O en estaciones de tren y metro gracias al caminar de la gente. Pero hace falta más, siempre más, la energía es una de esas cosas que si sobran, tanto mejor.

Entonces en Irlanda han decidido aprovechar la fuerza implacable de las corrientes submarinas, que en la zona de Strangford Narrows es muy fuerte, y han diseñado una especie de molino submarino, parte de un ambicioso proyecto denominado SeaGen. Por fuera se ve como un faro en medio de una bahía, pero debajo del nivel de la superficie las corrientes marinas generan electricidad gracias al giro de dos aspas de más de 15 metros de largo.

Que giran en ambas direcciones (horaria y antihoraria) para asegurarse que cualquiera sea la dirección de la corriente, se genere electricidad. Para evitar masacres submarinas, las aspas serán capaces de generar buena electricidad con solo moverse a una velocidad de entre 10 y 20 rpm, lo que permitirá a todas las criaturas del agua alejarse sin peligro alguno. Algo que no será igual de verdad para nadadores y buzos, que sin dudas deberán extremar precauciones cuando se encuentren en la zona.

Con esa configuración, la turbina será capaz de generar 1,2 megawatts de energía, que entregará a las casas de la costa. La buena noticia es que si este proyecto SeaGen prospera, pronto llegará el turno de una turbina aún mayor que será instalada en Gales.

fuente: Willy Klew

Publicado por

NicoMax

0

comentarios

![]()

Etiquetas: Tecnologia